Exporter des données de table vers Cloud Storage (original) (raw)

Cette page explique comment exporter ou extraire des données des tables BigQuery vers Cloud Storage.

Une fois que vous avez chargé des données dans BigQuery, vous pouvez les exporter sous plusieurs formats. BigQuery peut exporter jusqu'à 1 Go de données logiques dans un seul fichier. Si les données dépassent 1 Go, vous devez les exporter dans plusieurs fichiers. Le cas échéant, la taille des fichiers varie.

Vous pouvez également exporter les résultats d'une requête à l'aide de l'instruction EXPORT DATA. Vous pouvez utiliser EXPORT DATA OPTIONS pour spécifier le format des données exportées.

Enfin, vous pouvez utiliser un service tel que Dataflow pour lire les données de BigQuery au lieu de les exporter depuis BigLake. Pour en savoir plus sur l'utilisation de Dataflow afin de lire et d'écrire dans BigQuery, consultez la documentation sur les E/S BigQuery.

Limites en termes d'exportation

Lorsque vous exportez des données depuis BigQuery, tenez compte des points suivants :

- Vous ne pouvez pas exporter de données de table vers un fichier local, Google Sheets ou Google Drive. La seule zone d'exportation acceptée est Cloud Storage. Pour en savoir plus sur l'enregistrement des résultats de requête, consultez la section Télécharger et enregistrer des résultats de requête.

- Vous pouvez exporter jusqu'à 1 Go de données de table logique dans un seul fichier. Si les données dépassent 1 Go, utilisez un caractère générique pour les exporter dans plusieurs fichiers. Le cas échéant, la taille des fichiers varie. Pour limiter la taille du fichier exporté, vous pouvez partitionner vos données et exporter chaque partition.

- La taille de fichier générée lorsque vous utilisez l'instruction

EXPORT DATAn'est pas garantie. - Le nombre de fichiers générés par une tâche d'extraction peut varier.

- Vous ne pouvez pas exporter des données imbriquées et répétées au format CSV. Ces données sont acceptées pour les exportations aux formats Avro, JSON et Parquet.

- Lorsque vous exportez des données au format JSON, les types de données INT64 (entier) sont encodés sous la forme de chaînes JSON, afin de préserver la précision 64 bits lorsque les données sont lues par d'autres systèmes.

- Vous ne pouvez pas exporter des données de plusieurs tables dans une seule tâche d'extraction.

- Lorsque vous exportez des données à l'aide de la console Google Cloud , vous ne pouvez pas choisir un type de compression autre que

GZIP. - Lorsque vous exportez une table au format JSON, les symboles

<,>et&sont convertis à l'aide de la notation Unicode\uNNNN, oùNest un chiffre hexadécimal. Par exemple,profit&lossdevientprofit\u0026loss. Cette conversion Unicode est effectuée pour éviter les failles de sécurité. - L'ordre des données dans la table exportée n'est pas garanti, sauf si vous utilisez l'instruction EXPORT DATA et spécifiez une clause

ORDER BYdansquery_statement. - BigQuery n'accepte pas les chemins de ressource Cloud Storage qui incluent plusieurs barres obliques consécutives après la double barre oblique initiale. Le nom des objets Cloud Storage peut contenir plusieurs barres obliques ("/") consécutives. Toutefois, BigQuery convertit les barres obliques consécutives en une seule. Par exemple, le chemin d'accès à la ressource suivant, bien qu'il soit valide dans Cloud Storage, ne fonctionne pas dans BigQuery :

gs://bucket/my//object//name. - Les nouvelles données chargées dans BigQuery pendant l'exécution d'un job d'extraction ne seront pas incluses dans ce job. Vous devez créer un job d'extraction pour exporter les nouvelles données.

Avant de commencer

Attribuez aux utilisateurs des rôles IAM (Identity and Access Management) incluant les autorisations nécessaires pour effectuer l'ensemble des tâches du présent document.

Autorisations requises

Pour effectuer les tâches décrites dans ce document, vous devez disposer des autorisations suivantes.

Autorisations pour exporter des données depuis une table BigQuery

Pour exporter des données à partir d'une table BigQuery, vous devez disposer de l'autorisation IAM bigquery.tables.export.

Chacun des rôles Cloud IAM prédéfinis suivants inclut l'autorisation bigquery.tables.export :

roles/bigquery.dataViewerroles/bigquery.dataOwnerroles/bigquery.dataEditorroles/bigquery.admin

Pour exécuter une tâche d'extraction, vous avez besoin de l'autorisation IAM bigquery.jobs.create.

Chacun des rôles IAM prédéfinis suivants inclut les autorisations dont vous avez besoin pour exécuter une tâche d'extraction :

roles/bigquery.userroles/bigquery.jobUserroles/bigquery.admin

Autorisations d'écrire les données dans le bucket Cloud Storage

Pour écrire les données dans un bucket Cloud Storage existant, vous devez disposer des autorisations IAM suivantes :

storage.objects.createstorage.objects.delete

Chacun des rôles IAM prédéfinis suivants inclut les autorisations dont vous avez besoin pour écrire les données dans un bucket Cloud Storage existant :

roles/storage.objectAdminroles/storage.admin

Pour en savoir plus sur les rôles et les autorisations IAM dans BigQuery, consultez la page Rôles prédéfinis et autorisations.

Formats d'exportation et types de compression

BigQuery accepte les formats de données et les types de compression suivants pour les données exportées.

| Format des données | Types de compression acceptés | Détails |

|---|---|---|

| CSV | GZIP | Vous pouvez contrôler le délimiteur CSV dans vos données exportées à l'aide de l'option --field_delimiter de l'outil de ligne de commande bq ou de la propriété du job d'extraction configuration.extract.fieldDelimiter. Les données imbriquées et répétées ne sont pas acceptées. |

| JSON | GZIP | Les données imbriquées et répétées sont acceptées. |

| Avro | DEFLATE, SNAPPY | GZIP n'est pas compatible avec les exportations au format Avro. Les données imbriquées et répétées sont acceptées. Consultez la section Détails sur les exportations au format Avro. |

| Parquet | SNAPPY, GZIP, ZSTD | Les données imbriquées et répétées sont acceptées. Consultez la section Détails sur les exportations au format Parquet. |

Exporter les données

Les sections suivantes vous expliquent comment exporter les données et les métadonnées de vos tables, ainsi que les résultats de vos requêtes vers Cloud Storage.

Les exporter

Vous pouvez exporter les données de la table de plusieurs façons :

- Utiliser la console Google Cloud

- En utilisant la commande bq extract de l'outil de ligne de commande bq

- En envoyant un job

extractvia l'API ou les bibliothèques clientes

Sélectionnez l'une des options suivantes :

Console

- Ouvrez la page BigQuery dans la console Google Cloud .

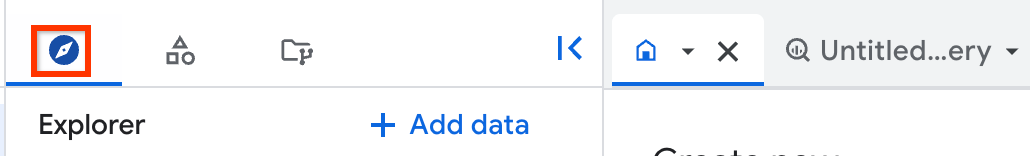

Accéder à la page "BigQuery" - Dans le panneau de gauche, cliquez sur Explorer :

Si le volet de gauche n'apparaît pas, cliquez sur Développer le volet de gauche pour l'ouvrir. - Dans le volet Explorateur, développez votre projet, cliquez sur Ensembles de données, puis sur votre ensemble de données.

- Cliquez sur Vue d'ensemble > Tables, puis sélectionnez une table.

- Dans le volet des détails, cliquez sur Importer Exporter.

- Dans la boîte de dialogue Exporter vers Google Cloud Storage :

- Dans le champ Emplacement GCS, recherchez le bucket, le dossier ou le fichier dans lequel vous souhaitez exporter les données.

- Pour le champ Format d'exportation, choisissez le format des données exportées : CSV, JSON (délimité par un retour à la ligne), Avro ou Parquet.

- Pour le champ Compression, sélectionnez un format de compression ou

Nonepour n'appliquer aucune compression.

- Cliquez sur Enregistrer pour exporter le tableau.

Pour vérifier la progression de la tâche, dans le volet Explorer, cliquez sur Historique des tâches, puis recherchez une tâche de type EXTRACT.

Pour exporter des vues vers Cloud Storage, utilisez l'instruction EXPORT DATA OPTIONS.

SQL

Utilisez l'instruction EXPORT DATA. L'exemple suivant exporte les champs sélectionnés à partir d'une table nommée mydataset.table1 :

- Dans la console Google Cloud , accédez à la page BigQuery.

Accéder à BigQuery - Dans l'éditeur de requête, saisissez l'instruction suivante :

EXPORT DATA

OPTIONS (

uri = 'gs://bucket/folder/*.csv',

format = 'CSV',

overwrite = true,

header = true,

field_delimiter = ';')

AS (

SELECT field1, field2

FROM mydataset.table1

ORDER BY field1

); - Cliquez sur Exécuter.

Pour en savoir plus sur l'exécution des requêtes, consultez Exécuter une requête interactive.

bq

Exécutez la commande bq extract avec l'option --destination_format.

(Facultatif) Spécifiez l'option --location et définissez la valeur correspondant à votre emplacement.

Les autres options facultatives sont les suivantes :

--compression: type de compression à utiliser pour les fichiers exportés.--field_delimiter: caractère indiquant la délimitation entre les colonnes du fichier de sortie pour les exportations au format CSV. Les options\tettabsont autorisées pour les délimiteurs de tabulation.--print_header: si spécifié, affiche les lignes d'en-tête pour les formats comportant des en-têtes (par exemple, les fichiers CSV).

bq extract --location=location

--destination_format format

--compression compression_type

--field_delimiter delimiter

--print_header=boolean

project_id:dataset.table

gs://bucket/filename.ext

Où :

- location est le nom du site. L'option

--locationest facultative. Par exemple, si vous utilisez BigQuery dans la région de Tokyo, vous pouvez définir la valeur de l'option surasia-northeast1. Vous pouvez définir une valeur par défaut correspondant à l'emplacement en utilisant le fichier .bigqueryrc. - format est le format des données exportées :

CSV,NEWLINE_DELIMITED_JSON,AVROouPARQUET. - compression_type est un type de compression compatible pour votre format de données. Consultez la page Formats d'exportation et types de compression.

- delimiter est le caractère qui indique la limite entre les colonnes dans les exportations au format CSV.

\tettabsont les noms acceptés pour la tabulation. - boolean est

trueoufalse. Lorsque la valeur esttrue, les lignes d'en-tête sont imprimées dans les données exportées si le format de ces dernières accepte les en-têtes. La valeur par défaut esttrue. - project_id est l'ID de votre projet.

- dataset est le nom de l'ensemble de données source.

- table est la table que vous exportez. Si vous utilisez un décorateur de partition, vous devez placer le chemin d'accès à la table entre guillemets simples ou échapper le caractère

$. - bucket est le nom du bucket Cloud Storage vers lequel vous exportez les données. L'ensemble de données BigQuery et le bucket Cloud Storage doivent se trouver dans le même emplacement.

- filename.ext est le nom et l'extension du fichier de données exporté. Pour effectuer l'exportation dans plusieurs fichiers, utilisez un caractère générique.

Exemples :

Par exemple, la commande suivante permet d'exporter mydataset.mytable dans un fichier compressé gzip nommé myfile.csv. myfile.csv est stocké dans un bucket Cloud Storage nommé example-bucket.

bq extract

--compression GZIP

'mydataset.mytable'

gs://example-bucket/myfile.csv

Le format de destination par défaut est CSV. Pour exporter au format JSON ou Avro, spécifiez l'option destination_format, puis définissez-le sur NEWLINE_DELIMITED_JSON ou AVRO. Exemple :

bq extract

--destination_format NEWLINE_DELIMITED_JSON

'mydataset.mytable'

gs://example-bucket/myfile.json

La commande suivante permet d'exporter mydataset.mytable dans un fichier Avro compressé à l'aide de Snappy. Le fichier se nomme myfile.avro. myfile.avro est exporté vers un bucket Cloud Storage nommé example-bucket.

bq extract

--destination_format AVRO

--compression SNAPPY

'mydataset.mytable'

gs://example-bucket/myfile.avro

La commande suivante exporte une seule partition de mydataset.my_partitioned_table dans un fichier CSV dans Cloud Storage :

bq extract

--destination_format CSV

'mydataset.my_partitioned_table$0'

gs://example-bucket/single_partition.csv

API

Pour exporter des données, créez une tâche extract et insérez la configuration de la tâche.

(Facultatif) Spécifiez votre emplacement dans la propriété location de la section jobReference de la ressource de tâche.

- Créez une tâche d'extraction qui pointe vers les données sources BigQuery et la destination Cloud Storage.

- Spécifiez la table source à l'aide de l'objet de configuration

sourceTablecontenant les ID du projet, de l'ensemble de données et de la table. - La propriété

destination URI(s)doit être complète et respecter le formatgs://bucket/filename.ext. Chaque URI peut contenir un caractère générique "*", qui doit être placé après le nom du bucket. - Spécifiez le format de données en définissant la propriété

configuration.extract.destinationFormat. Par exemple, pour exporter un fichier JSON, définissez cette propriété sur la valeurNEWLINE_DELIMITED_JSON. - Pour vérifier l'état de la tâche, appelez jobs.get(job_id) avec l'ID de la tâche renvoyée par la requête initiale.

- Si la réponse est

status.state = DONE, la tâche a bien été exécutée. - Si la propriété

status.errorResultest présente, la requête a échoué. Cet objet inclura des informations décrivant le problème rencontré. - Si la propriété

status.errorResultest absente, le job a bien été exécuté. Toutefois, des erreurs non fatales ont pu se produire. Ces erreurs sont regroupées dans la propriétéstatus.errorsde l'objet de job renvoyé.

- Si la réponse est

Remarques relatives à l'API :

- Nous vous recommandons de générer un ID unique et de le transmettre en tant que

jobReference.jobIdlorsque vous appelezjobs.insertpour créer une tâche. Cette approche offre une protection plus robuste contre les pannes réseau, car le client peut lancer une requête ou effectuer de nouvelles tentatives en utilisant l'ID de tâche connu. - L'appel de

jobs.insertavec un ID de tâche donné est idempotent. En d'autres termes, vous pouvez effectuer autant de tentatives que vous le souhaitez avec le même ID de tâche. L'une de ces opérations tout au plus aboutira.

C#

Avant d'essayer cet exemple, suivez les instructions de configuration pour C# du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour C#.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Go

Avant d'essayer cet exemple, suivez les instructions de configuration pour Go du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Go.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Java

Avant d'essayer cet exemple, suivez les instructions de configuration pour Java du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Java.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Node.js

Avant d'essayer cet exemple, suivez les instructions de configuration pour Node.js du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Node.js.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

PHP

Avant d'essayer cet exemple, suivez les instructions de configuration pour PHP du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour PHP.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Python

Avant d'essayer cet exemple, suivez les instructions de configuration pour Python du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Python.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Ruby

Avant d'essayer cet exemple, suivez les instructions de configuration pour Ruby du guide de démarrage rapide de BigQuery : Utiliser les bibliothèques clientes. Pour en savoir plus, consultez la documentation de référence de l'API BigQuery pour Ruby.

Pour vous authentifier auprès de BigQuery, configurez le service Identifiants par défaut de l'application. Pour en savoir plus, consultez la page Configurer l'authentification pour les bibliothèques clientes.

Exporter les métadonnées de table

Pour exporter les métadonnées d'une table Iceberg, utilisez l'instruction SQL suivante :

EXPORT TABLE METADATA FROM [[PROJECT_NAME.]DATASET_NAME.]TABLE_NAME;

Remplacez les éléments suivants :

- PROJECT_NAME : nom du projet pour la table. La valeur par défaut correspond au projet qui exécute cette requête.

- DATASET_NAME : nom de l'ensemble de données de la table.

- TABLE_NAME : nom de la table

Les métadonnées exportées se trouvent dans le dossier STORAGE_URI/metadata, où STORAGE_URI correspond à l'emplacement de stockage de la table défini dans les options.

Exporter des résultats de requête

Vous pouvez exporter les résultats de vos requêtes vers Cloud Storage dans la console Google Cloud en procédant comme suit :

- Ouvrez la page BigQuery dans la console Google Cloud .

Accéder à la page "BigQuery" - Cliquez sur Requête SQL.

- Saisissez une requête GoogleSQL valide dans la zone de texte de l'éditeur de requête.

- Cliquez sur Exécuter.

- Lorsque les résultats sont renvoyés, cliquez sur Enregistrer les résultats > Cloud Storage.

- Dans la boîte de dialogue Exporter vers Google Cloud Storage :

- Dans le champ Emplacement GCS, recherchez le bucket, le dossier ou le fichier dans lequel vous souhaitez exporter les données.

- Pour le champ Format d'exportation, choisissez le format des données exportées : CSV, JSON (délimité par un retour à la ligne), Avro ou Parquet.

- Pour le champ Compression, sélectionnez un format de compression ou

Nonepour n'appliquer aucune compression.

- Cliquez sur Enregistrer pour exporter les résultats de la requête.

Pour vérifier la progression de la tâche, développez le volet Historique des tâches et recherchez la tâche de type EXTRACT.

Détails sur les exportations au format Avro

BigQuery exprime les données au format Avro comme suit :

- Les fichiers d'exportation obtenus sont des fichiers de conteneur Avro.

- Chaque ligne BigQuery est représentée par un enregistrement Avro. Les données imbriquées sont représentées par des objets Enregistrement imbriqués.

- Les champs

REQUIREDsont représentés par les types Avro correspondants. Par exemple, un typeINTEGERBigQuery est mappé sur un typeLONGAvro. - Les champs

NULLABLEsont représentés par une union Avro du type correspondant et la valeur "null". - Les champs

REPEATEDsont représentés par des tableaux Avro. - Les types de données

TIMESTAMPsont représentés par le type logiquetimestamp-micros(il annote un typeLONGAvro) par défaut dans les tâches d'extraction et d'exportation des données SQL. (Attention : vous pouvez ajouteruse_avro_logical_types=FalseàExport Data Optionspour désactiver le type logique afin d'utiliser le typestringde la colonne de code temporel. Toutefois, il utilise toujours le type logique Avro dans les jobs d'extraction.) - Les types de données

DATEsont représentés par le type logiquedate(il annote un typeINTAvro) par défaut dans les tâches d'exportation des données SQL, mais ils sont représentés par le typestringpar défaut dans les tâches d'extraction. (Remarque : vous pouvez ajouteruse_avro_logical_types=FalseàExport Data Optionspour désactiver le type logique ou utiliser l'option--use_avro_logical_types=Truepour activer le type logique dans les tâches d'extraction.) - Les types de données

TIMEsont représentés par le type logiquetimestamp-micro(il annote un typeLONGAvro) par défaut dans les tâches d'exportation des données SQL, mais ils sont représentés par le typestringpar défaut dans les tâches d'extraction. (Remarque : vous pouvez ajouteruse_avro_logical_types=FalseàExport Data Optionspour désactiver le type logique ou utiliser l'option--use_avro_logical_types=Truepour activer le type logique dans les tâches d'extraction.) - Les types de données

DATETIMEsont représentés par des typesSTRINGAvro (un type de chaîne avec le type logique personnalisédatetime) par défaut dans les tâches d'exportation des données SQL, mais sont représentés par le typestringpar défaut dans les tâches d'extraction. (Remarque : vous pouvez ajouteruse_avro_logical_types=FalseàExport Data Optionspour désactiver le type logique ou utiliser l'option--use_avro_logical_types=Truepour activer le type logique dans les tâches d'extraction.) - Les types RANGE ne sont pas acceptés dans les exportations Avro.

Les types de données paramétrés NUMERIC(P[, S]) et BIGNUMERIC(P[, S]) transfèrent leurs paramètres de type précision et échelle vers le type logique décimal Avro.

Le format Avro ne peut pas être utilisé en association avec la compression GZIP. Pour compresser des données Avro, utilisez l'outil de ligne de commande bq ou l'API, et spécifiez l'un des types de compression acceptés pour ces données : DEFLATE ou SNAPPY.

Détails sur les exportations au format Parquet

BigQuery convertit les types de données GoogleSQL en types de données au format Parquet suivants :

| Type de données BigQuery | Type primitif Parquet | Type logique Parquet |

|---|---|---|

| Entier | INT64 | NONE |

| Numérique | FIXED_LEN_BYTE_ARRAY | DECIMAL (precision = 38, scale = 9) |

| Numerique(P[, S]) | FIXED_LEN_BYTE_ARRAY | DECIMAL (precision = P, scale = S) |

| BigNumeric | FIXED_LEN_BYTE_ARRAY | DECIMAL (precision = 76, scale = 38) |

| BigNumeric(P[, S]) | FIXED_LEN_BYTE_ARRAY | DECIMAL (precision = P, scale = S) |

| Virgule flottante | FLOAT | NONE |

| Booléen | BOOLEAN | NONE |

| Chaîne | BYTE_ARRAY | STRING (UTF8) |

| Octets | BYTE_ARRAY | NONE |

| Date | INT32 | DATE |

| Date/Heure | INT64 | TIMESTAMP (isAdjustedToUTC = false, unit = MICROS) |

| Heure | INT64 | TIME (isAdjustedToUTC = true, unit = MICROS) |

| Horodatage | INT64 | TIMESTAMP (isAdjustedToUTC = false, unit = MICROS) |

| Zone géographique | BYTE_ARRAY | GEOGRAPHY (edges = spherical) |

Le schéma Parquet représente les données imbriquées sous forme de groupe et les enregistrements répétés sous forme de groupes répétés. Pour plus d'informations sur l'utilisation de données imbriquées et répétées dans BigQuery, consultez la section Spécifier des colonnes imbriquées et répétées.

Vous pouvez utiliser les solutions suivantes pour les types DATETIME :

- Chargez le fichier dans une table de transfert. Ensuite, utilisez une requête SQL pour convertir le champ en

DATETIMEet enregistrez le résultat dans une nouvelle table. Pour en savoir plus, consultez la section Modifier le type de données d'une colonne. - Fournissez un schéma pour la table à l'aide de l'option

--schemade la tâche de chargement. Définissez la colonne date/heure en tant quecol:DATETIME.

Le type logique GEOGRAPHY est représenté par des métadonnées GeoParquet ajoutées aux fichiers exportés.

Exporter des données dans un ou plusieurs fichiers

La propriété destinationUris indique le ou les emplacements et noms de fichiers dans lesquels BigQuery doit exporter vos fichiers.

BigQuery accepte un seul opérateur générique (*) dans chaque URI. Le caractère générique peut apparaître n'importe où dans le nom de fichier. L'opérateur générique permet d'indiquer à BigQuery qu'il doit créer plusieurs fichiers segmentés en fonction du modèle fourni. Cet opérateur est remplacé par un numéro (en commençant à 0) et il est complété à gauche de façon à obtenir 12 chiffres. Par exemple, un URI avec un caractère générique à la fin du nom du fichier crée des fichiers où 000000000000 est ajouté au premier fichier, 000000000001 est ajouté au deuxième fichier, et ainsi de suite.

Le tableau suivant décrit plusieurs options possibles pour la propriété destinationUris :

| Options destinationUris | |

|---|---|

| Un seul URI | Utilisez un seul URI si vous exportez des données de table d'une taille inférieure ou égale à 1 Go. Cette option est le cas d'utilisation le plus courant, car les données exportées sont généralement inférieures à la valeur maximale de 1 Go. Cette option n'est pas compatible avec l'instruction EXPORT DATA. Vous devez utiliser un seul URI générique. Définition de la propriété : ['gs://my-bucket/file-name.json'] Crée : gs://my-bucket/file-name.json |

| Un seul URI générique | Un seul caractère générique peut être utilisé dans le composant de nom de fichier de l'URI. Utilisez un seul URI générique si vous pensez que les données exportées dépasseront la valeur maximale de 1 Go. BigQuery segmente les données en plusieurs fichiers en fonction du modèle fourni. La taille des fichiers exportés varie. Définition de la propriété : ['gs://my-bucket/file-name-*.json'] Crée : gs://my-bucket/file-name-000000000000.json gs://my-bucket/file-name-000000000001.json gs://my-bucket/file-name-000000000002.json ... ['gs://my-bucket/*'] Crée : gs://my-bucket/000000000000 gs://my-bucket/000000000001 gs://my-bucket/000000000002 ... |

Limiter la taille du fichier exporté

Lorsque vous exportez plus de 1 Go de données en une seule exportation, vous devez utiliser un caractère générique pour exporter les données dans plusieurs fichiers et la taille des fichiers varie. Si vous devez limiter la taille maximale de chaque fichier exporté, vous pouvez partitionner vos données de manière aléatoire, puis exporter chaque partition vers un fichier :

- Déterminez le nombre de partitions dont vous avez besoin, qui est égal à la taille totale de vos données divisée par la taille de fichier exportée souhaitée. Par exemple, si vous disposez de 8 000 Mo de données et que vous souhaitez que chaque fichier exporté fasse environ 20 Mo, vous avez besoin de 400 partitions.

- Créez une table partitionnée et mise en cluster par une nouvelle colonne générée de manière aléatoire appelée

export_id. L'exemple suivant montre comment créer une tableprocessed_tableà partir d'une table existante appeléesource_tablequi nécessite des partitionsnpour atteindre la taille de fichier souhaitée :

CREATE TABLE my_dataset.processed_table

PARTITION BY RANGE_BUCKET(export_id, GENERATE_ARRAY(0, n, 1))

CLUSTER BY export_id

AS (

SELECT , CAST(FLOOR(nRAND()) AS INT64) AS export_id

FROM my_dataset.source_table

); - Pour chaque entier

icompris entre 0 etn-1, exécutez une instructionEXPORT DATAsur la requête suivante :

SELECT * EXCEPT(export_id)

FROM my_dataset.processed_table

WHERE export_id = i;

Exemple d'utilisation

Cet exemple montre comment exporter des données vers Cloud Storage.

Supposons que vous insérez des données en flux continu dans Cloud Storage à partir de journaux de points de terminaison de manière continue. Un instantané quotidien doit être exporté vers Cloud Storage à des fins de sauvegarde et d'archivage. Le meilleur choix est une tâche d'extraction soumise à certains quotas et limites.

Envoyez une tâche d'extraction avec l'API ou les bibliothèques clientes, en transmettant un ID unique en tant que jobReference.jobId. Les tâches d'extraction sont asynchrones.Vérifiez l'état de la tâche à l'aide de l'ID de tâche unique utilisé pour la créer. La tâche a bien été exécutée si status.status est défini sur DONE. Si status.errorResult est présent, la tâche a échoué et doit être relancée.

Traitement de données par lot

Supposons qu'une tâche par lot quotidienne soit utilisée pour charger des données dans un délai fixe. Une fois cette tâche de chargement terminée, une table avec des statistiques est matérialisée à partir d'une requête, comme décrit dans la section précédente. Les données de cette table sont extraites et compilées dans un rapport PDF et envoyées à un régulateur.

La quantité de données à lire étant petite, utilisez l'API tabledata.list pour récupérer toutes les lignes de la table au format de dictionnaire JSON. S'il existe plusieurs pages de données, la propriété pageToken sera définie dans les résultats. Pour extraire la page de résultats suivante, effectuez un autre appel tabledata.list et incluez la valeur du jeton en tant que paramètre pageToken. Si l'appel d'API échoue avec une erreur 5xx, réessayez avec un intervalle exponentiel entre les tentatives. La plupart des erreurs 4xx ne peuvent pas faire l'objet d'une nouvelle tentative. Pour un meilleur découplage de l'exportation BigQuery et de la génération de rapports, les résultats doivent être conservés sur le disque.

Règles de quotas

Pour en savoir plus sur les quotas appliqués aux tâches d'extraction, consultez la section Tâches d'extraction de la page "Quotas et limites".

L'utilisation pour les tâches d'extraction est disponible dans le champ INFORMATION_SCHEMA. L'entrée du job dans les tables système JOBS_BY_* pour le job d'extraction contiendra une valeur total_bytes_processed qui peut être utilisée pour surveiller l'utilisation globale afin de s'assurer qu'elle reste inférieure à 50 To par jour. Pour savoir comment interroger la vue INFORMATION_SCHEMA.JOBS pour obtenir la valeur total_bytes_processed, consultez la section Schéma INFORMATION_SCHEMA.JOBS.

Afficher l'utilisation actuelle des quotas

Vous pouvez afficher l'utilisation actuelle des jobs de requête, de chargement, d'extraction ou de copie en exécutant une requête INFORMATION_SCHEMA pour afficher les métadonnées des tâches exécutées sur une période spécifiée. Vous pouvez comparer votre utilisation actuelle à la limite de quota pour déterminer votre utilisation de quotas pour un type de job particulier. L'exemple de requête suivant utilise la vue INFORMATION_SCHEMA.JOBS pour répertorier le nombre de jobs de requête, de chargement, d'extraction et de copie par projet :

SELECT

sum(case when job_type="QUERY" then 1 else 0 end) as QRY_CNT,

sum(case when job_type="LOAD" then 1 else 0 end) as LOAD_CNT,

sum(case when job_type="EXTRACT" then 1 else 0 end) as EXT_CNT,

sum(case when job_type="COPY" then 1 else 0 end) as CPY_CNT

FROM region-REGION_NAME.INFORMATION_SCHEMA.JOBS_BY_PROJECT

WHERE date(creation_time)= CURRENT_DATE()

Vous pouvez configurer une règle d'alerte Cloud Monitoring qui surveille le nombre d'octets exportés.

- Dans la console Google Cloud , accédez à la page Alertes :

Accéder à la page Alertes

Si vous utilisez la barre de recherche pour trouver cette page, sélectionnez le résultat dont le sous-titre est Monitoring. - Sur la page Alertes, cliquez sur Créer une règle.

- Sous Mode de configuration des règles, sélectionnez Éditeur de code (MQL ou PromQL).

- Dans l'éditeur de requête PromQL, saisissez la requête suivante :

(

sum by (project_id, quota_metric, location) (increase({"serviceruntime.googleapis.com/quota/rate/net_usage", monitored_resource="consumer_quota", service="bigquery.googleapis.com"}[1m]))

/

max by (project_id, quota_metric, location) ({"serviceruntime.googleapis.com/quota/limit", monitored_resource="consumer_quota", service="bigquery.googleapis.com", limit_name="ExtractBytesPerDay"})

) > 0.01 Si l'option Exécution automatique n'est pas activée, cliquez sur Exécuter la requête. 5. Configurez le reste de votre alerte, puis cliquez sur Créer une règle.

Pour obtenir la procédure détaillée de création de règles d'alerte basées sur PromQL, consultez Créer des règles d'alerte basées sur PromQL (console).

Dépannage

Diagnostiquer et résoudre les problèmes liés aux jobs d'extraction.

Diagnostiquer les problèmes à l'aide de l'explorateur de journaux

Pour diagnostiquer les problèmes liés aux jobs d'extraction, vous pouvez utiliser l'explorateur de journaux afin d'examiner les journaux d'un job d'extraction spécifique et d'identifier les erreurs éventuelles. Le filtre Explorateur de journaux suivant renvoie des informations sur vos jobs d'extraction :

resource.type="bigquery_resource"

protoPayload.methodName="jobservice.insert"

(protoPayload.serviceData.jobInsertRequest.resource.jobConfiguration.query.query=~"EXPORT" OR

protoPayload.serviceData.jobCompletedEvent.eventName="extract_job_completed" OR

protoPayload.serviceData.jobCompletedEvent.job.jobConfiguration.query.query=~"EXPORT")

BigQuery renvoie cette erreur lorsque l'extraction dépasse la limite quotidienne par défaut de 50 Tio dans un projet. Pour en savoir plus sur les limites des tâches d'extraction, consultez Tâches d'extraction.

Message d'erreur

Your usage exceeded quota for ExtractBytesPerDay

Si vous exportez une table de plus de 50 Tio, l'exportation échoue, car elle dépasse la limite d'extraction. Si vous souhaitez exporter des données de table pour des partitions de table spécifiques, vous pouvez utiliser un décorateur de partition pour identifier les partitions à exporter.

Si vous souhaitez collecter des données sur l'utilisation des exportations au cours des derniers jours, vous pouvez essayer ce qui suit :

- Affichez les quotas de votre projet avec des critères de filtrage tels que

Name: Extract bytes per dayouMetric: bigquery.googleapis.com/quota/extract/bytes, ainsi que le graphique "Afficher l'utilisation" pour voir votre tendance d'utilisation sur quelques jours. - Vous pouvez également interroger INFORMATION_SCHEMA.JOBS_BY_PROJECT pour afficher le nombre total d'octets extraits sur plusieurs jours. Par exemple, la requête suivante renvoie le nombre total d'octets traités quotidiennement par les jobs

EXTRACTau cours des sept derniers jours.

SELECT

TIMESTAMP_TRUNC(creation_time, DAY) AS day,

SUM ( total_bytes_processed ) / POW(1024, 3) AS total_gibibytes_processed

FROMregion-REGION_NAME.INFORMATION_SCHEMA.JOBS_BY_PROJECT

WHERE

creation_time BETWEEN TIMESTAMP_SUB(CURRENT_TIMESTAMP(), INTERVAL 7 DAY) AND CURRENT_TIMESTAMP()

AND job_type = "EXTRACT"

GROUP BY 1

ORDER BY 2 DESC - Vous pouvez ensuite affiner davantage les résultats en identifiant les tâches spécifiques qui consomment plus d'octets que prévu. L'exemple suivant renvoie les 100 principaux jobs

EXTRACTqui consomment plus de 100 Go de données traitées au cours des sept derniers jours.

SELECT

creation_time,

job_id,

total_bytes_processed/POW(1024, 3) AS total_gigabytes_processed

FROMregion-REGION_NAME.INFORMATION_SCHEMA.JOBS_BY_PROJECT

WHERE

creation_time BETWEEN TIMESTAMP_SUB(CURRENT_TIMESTAMP(), INTERVAL 7 DAY) AND CURRENT_TIMESTAMP()

AND job_type="EXTRACT"

AND total_bytes_processed > (POW(1024, 3) * 100)

ORDER BY

total_bytes_processed DESC

LIMIT 100

Vous pouvez également utiliser l'explorateur de jobs avec des filtres tels que Bytes processed more than pour filtrer les jobs à traitement élevé pour une période donnée.

Pour résoudre cette erreur de quota, vous pouvez créer une réservation d'emplacement et attribuer votre projet à la réservation avec le type de tâche PIPELINE. Cette méthode peut contourner la vérification des limites, car elle utilise vos réservations dédiées plutôt qu'un pool d'emplacements partagés gratuit. Si nécessaire, vous pouvez supprimer la réservation si vous souhaitez utiliser un pool d'emplacements partagés ultérieurement.

Pour découvrir d'autres approches permettant d'exporter plus de 50 Tio, consultez la section des notes dans Tâches d'extraction.

Tarifs

Pour en savoir plus sur la tarification de l'exportation de données, consultez la page Tarifs de BigQuery.

Une fois les données exportées, leur stockage dans Cloud Storage vous est facturé. Pour en savoir plus, consultez la page Tarifs de Cloud Storage.

Sécurité des tables

Pour savoir comment contrôler l'accès aux tables dans BigQuery, consultez Contrôler l'accès aux ressources avec IAM.

Étapes suivantes

- Pour en savoir plus sur la console Google Cloud , consultez Utiliser la console Google Cloud .

- Pour en savoir plus sur l'outil de ligne de commande bq, consultez la page Utiliser l'outil de ligne de commande bq.

- Pour découvrir comment créer une application à l'aide des bibliothèques clientes de l'API BigQuery, consultez le guide de démarrage rapide des bibliothèques clientes.