Definición de Informática (original) (raw)

Definición de Informática

La informática es la ciencia que estudia el tratamiento automático de la información en computadoras, dispositivos electrónicos y sistemas informáticos.

La informática estudia los métodos y técnicas para almacenar, procesar y transmitir información y datos de forma automatizada. En otras palabras, estudia el uso de la computación y sus aplicaciones.

La informática se basa en múltiples ciencias como la matemática, la física, la electrónica, etc.

Su desarrollo comenzó a mediados del siglo XX, con grandes avances como el circuito integrado, la llegada de la PC, internet y el teléfono móvil.

De hecho la informática ha dado origen a la llamada Era de la Información, propulsora de la Revolución de la Información, visto como el tercer mayor progreso tecnológico de la humanidad junto con la Revolución Industrial (1750–1850, de nuestra era) y la Revolución Neolítica (agricultura) (8000–5000 antes de Cristo).

La informática se ha convertido en una disciplina fundamental en el mundo moderno, siendo aplicada en una amplia gama de áreas como la medicina, la ingeniería, la educación, la economía, entre muchas otras. Su importancia radica en su capacidad para simplificar y agilizar tareas complejas, así como para resolver problemas de manera eficiente.

En la actualidad, la informática ha evolucionado de manera vertiginosa, dando lugar a la inteligencia artificial y al machine learning, que permiten a las máquinas aprender y mejorar sus capacidades de forma autónoma. Además, la interconexión global a través de internet ha permitido la creación de un vasto y complejo ecosistema digital, en el que se generan grandes cantidades de datos que pueden ser analizados para obtener información valiosa.

La informática también ha transformado radicalmente la forma en que nos comunicamos y nos relacionamos, facilitando el intercambio de información en tiempo real a través de redes sociales, aplicaciones de mensajería instantánea y videoconferencias. Esto ha estrechado distancias y ha permitido una mayor colaboración entre individuos y empresas, sin importar su ubicación geográfica.

Sin embargo, el creciente avance de la informática también plantea desafíos y preocupaciones, como la seguridad informática y la privacidad de los datos. A medida que nuestras vidas se vuelven cada vez más digitales, es importante asegurar que la información personal y los sistemas de información estén protegidos de amenazas cibernéticas.

En conclusión, la informática ha revolucionado la forma en que procesamos y utilizamos la información, generando grandes avances tecnológicos y transformando nuestra sociedad en la Era de la Información. A medida que la tecnología continúa evolucionando, la informática seguirá jugando un papel fundamental en nuestro desarrollo y progreso.

Definición de informática

La informática es el estudio sistemático de la viabilidad, estructura, expresión y mecanización de procedimiento metódicos (o algoritmos) que subyacen a la adquisición, representación, procesamiento, almacenamiento, comunicación y acceso a la información.

Origen del término informática

Proviene del francés informatique y fue acuñado por el ingeniero Philippe Dreyfus en 1962. Formó una conjunción entre las palabras "information" y "automatique".

Otra fuentes dicen que proviene de la palabra alemana Informatik de un documento de 1957 escrito por Karl Steinbuch llamado Informatik: Automatische Informationsverarbeitung (Informática: procesamiento automático de información).

En tanto el inglés Walter F. Bauer, de forma independiente en el año 1962, cofundó la empresa denominada Informatics General.

En inglés es computer science.

Grandes contribuciones de la informática

- Inicio de la llamada Revolución digital o Revolución de la Información, que incluye internet y la Era de la Información.

- La concepción de los lenguajes de programación: herramientas de gran precisión de expresiones de información en varios niveles de abstracción.

- La criptografía. De hecho la victoria Aliada en la Segunda Guerra Mundial fue en gran parte debido a que fue quebrado el código Enigma alemán.

- La computación científica, que permite evaluar procesos y situaciones complejas, realizar experimentos completamente por software, y permite herramientas de predicción. Simulación de procesos físicos y químicos.

- Los algoritmos mejoran la eficiencia y liquidez de los mercados financieros, empleando inteligencia artificial y otras técnicas estadísticas y numéricas a gran escala.

- Los gráficos por computadora, que se usan para el entretenimiento: cine, televisión, publicidad, videojuegos.

- Optimización de máquinas, por ejemplo, la aviación moderna sería imposible sin la informática.

- La Inteligencia Artificial, probablemente sea el área donde mayores logros se verán en las próximas décadas.

Orígenes de la informática

Los fundamentos de la informática pueden remontarse cientos de años antes de la invención de la computadora digital moderna. Existían dispositivos o mecanismos para tareas de cálculos como el ábaco desde la antigüedad, incluso con cálculos más complejos como multiplicación y división.

En tanto los algoritmos para realizar cálculos han existido desde la antigüedad. Por ejemplo, los antiguos tratados sánscritos Shulba Sutras (o "Reglas de la cuerda"), son libros de algoritmos escritos por diversos autores alrededor del año 800 antes de Cristo para la construcción de objetos geométricos como altares de fuego utilizando una clavija y una cuerda, un precursor temprano del moderno campo de la geometría computacional. También contenía intentos de resolución de la cuadratura del círculo.

1600

Blaise Pascal diseñó y construyó la primera calculadora mecánica que funcionaba, la calculadora de Pascal, en el año 1642.

En 1673, Gottfried Leibniz demostró una calculadora digital mecánica llamada Stepped Reckoner. Él puede ser considerado el primer científico informático de la historia. Documentó, entre otras cosas, el sistema numérico binario.

1800

En 1820, Thomas de Colmar puso en marcha la primera calculadora mecánica industrial cuando lanzó su aritmómetro simplificado, fue la primera máquina de calcular lo suficientemente fuerte y lo suficientemente confiable para ser utilizada a diario en un entorno de oficina.

Charles Babbage (1791-1871), el padre de la computación

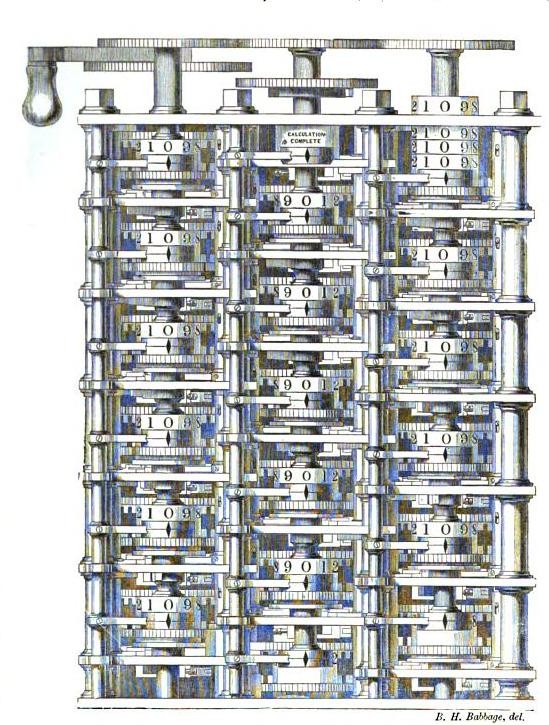

En 1822, Charles Babbage (1791-1871) comenzó el diseño de la primera calculadora mecánica automática, de nombre Difference Engine (Máquina diferencial). La cual eventualmente le dio la idea para la primera calculadora mecánica programable, su Analytical Engine (Máquina analítica).

Difference Engine o Máquina diferencial de Charles Babbage en 1833, exhibido en 1862.

Comenzó el desarrollo de esta máquina en 1834 y en menos de dos años hizo un boceto de todas las características más destacadas que tendría una computadora moderna actual. Un paso crucial fue la adopción de un sistema de tarjetas perforadas derivado del telar de Jacquard, lo que la hacía "infinitamente" programable.

En 1843, durante la traducción de un artículo en francés de Analytical Engine, Ada Lovelace (1815-1852) escribió el que es considerado hoy el primer programa de computación de la historia, servía para computar números de Bernoulli.

Ada Lovelace (1815-1852), escribió el primer programa de computación de la historia.

En 1885, Herman Hollerith inventó el tabulador, que era usado para procesar tarjetas perforadas con información estadística; eventualmente esta compañía sería parte de IBM.

1900

En 1937, cien años después del sueño imposible de Babbage, Howard Aiken convenció a IBM (que estaba haciendo todo tipo de equipos de tarjetas perforadas y estaba también en el negocio de las calculadoras), para desarrollar la calculadora programable gigante, la ASCC/Harvard Mark I, basada en el Analytical Engine de Babbage, que a su vez utilizan tarjetas y una unidad central de cálculo. Cuando la máquina se terminó de construir, algunos dijeron que era "el sueño de Babbage hecho realidad".

Durante la década de 1940, mientras se desarrollaban nuevas máquinas de cómputo, el término computador comenzó a referirse a las máquinas en lugar de personas (el término se empleaba antes para designar a aquel que se dedicaba a los cálculos).

Se volvió más claro que las computadoras podían emplearse en muchas más aplicaciones que simplemente cálculos matemáticos.

El primer programa de grado de ciencias de la computación (el Cambridge Diploma in Computer Science), fue entregado por la Universidad de Cambridge en 1953.

Sin dudas IBM fue la empresa que más aportó al conocimiento informático en estas décadas.

Con el pasar del tiempo, la informática pasó de ser un campo dominado por expertos y profesionales, a estar disponible y accesible para cualquiera que se interese en esta.

Analfabetismo informático

Hace referencia a la falta de conocimientos básicos acerca de las nuevas tecnologías.

Ver Analfabetismo informático.

Seguridad informática

Área especializada en la seguridad de la computación.

Ver el artículo completo aquí: Seguridad informática.

Resumen: Informática

La informática es la ciencia que estudia el tratamiento automático de la información en computadoras y dispositivos electrónicos. Se basa en diversas ciencias como matemáticas y física. Ha tenido grandes avances con la llegada de la PC, internet y el teléfono móvil, dando paso a la Era de la Información.

¿Cuál es la importancia de la informática en la actualidad?

La informática es fundamental en la sociedad actual, ya que permite el procesamiento, almacenamiento y transferencia de información de manera rápida y eficiente. Además, facilita la automatización de tareas, el acceso a la información y la comunicación a través de diferentes dispositivos electrónicos.

¿Cuáles son las principales ramas de la informática?

La informática se divide en diversas ramas, entre las más destacadas se encuentran: la informática teórica, que se encarga de estudiar los fundamentos y principios de la informática; la informática aplicada, que se enfoca en el desarrollo de aplicaciones y software; y la ciberseguridad, que se dedica a proteger los sistemas informáticos contra amenazas y ataques.

¿Qué requisitos se necesitan para estudiar informática?

Para estudiar informática es recomendable tener habilidades para el razonamiento lógico y matemático, así como interés por la resolución de problemas y el uso de tecnologías. Es importante contar con conocimientos básicos en programación y manejo de computadoras, aunque en muchos casos se pueden adquirir durante la formación académica.

¿Cuál es el campo laboral de un profesional en informática?

El campo laboral de un profesional en informática es amplio y diversificado. Puede desempeñarse como desarrollador de software, administrador de sistemas informáticos, especialista en redes y telecomunicaciones, consultor tecnológico, entre otros. Además, con el avance de la tecnología, existe una creciente demanda de expertos en inteligencia artificial, big data y ciberseguridad.

¿Cuáles son los beneficios de utilizar sistemas informáticos en las empresas?

El uso de sistemas informáticos en las empresas proporciona numerosos beneficios, como la optimización de procesos, la mejora en la toma de decisiones, la reducción de costos operativos, la automatización de tareas repetitivas, el acceso rápido a la información, la seguridad de datos y la posibilidad de tener una comunicación eficiente tanto interna como con los clientes.

¿Cuál es el impacto de la informática en la sociedad?

La informática ha tenido un gran impacto en la sociedad, facilitando la vida diaria de las personas en aspectos como las comunicaciones, el acceso a la información, la educación a distancia, el comercio electrónico, el entretenimiento, entre otros. Sin embargo, también ha generado desafíos, como la brecha digital y la seguridad informática, que deben ser abordados adecuadamente para aprovechar al máximo los beneficios de la tecnología.

Terminología relacionada

• Digital

Autor: Leandro Alegsa

Actualizado: 31-07-2023

¿Cómo citar este artículo?

Alegsa, Leandro. (2023). Definición de Informática. Recuperado de https://www.alegsa.com.ar/Dic/informatica.php